近日有外媒报道称,某公司使用的ClaudeBot在24小时之内就访问了iFixit网站近百万次,此举引得iFixit的CEO Kyle Wiens直接在X上开怼,表示该公司的爬虫行为完全违反了iFixit的使用条款。

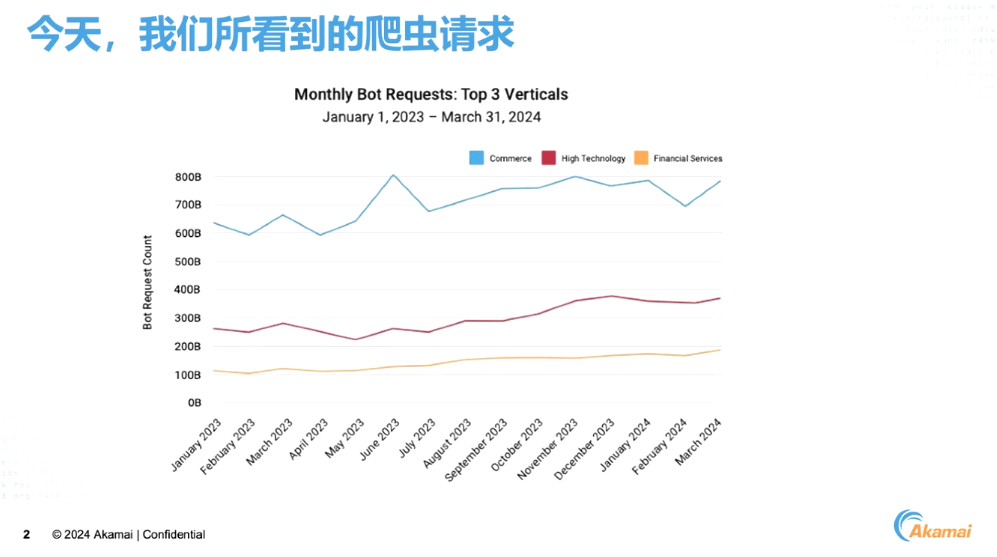

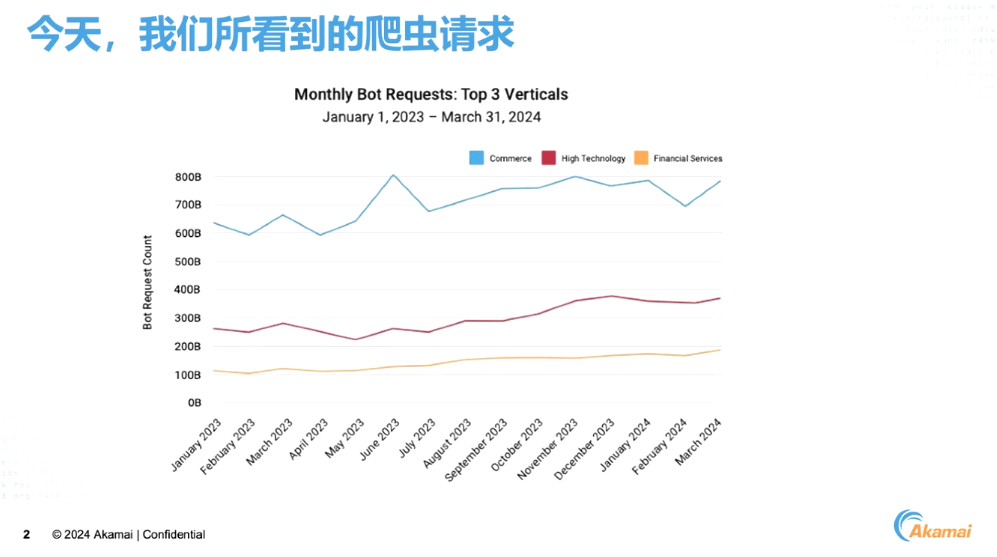

虽然ClaudeBot的爬虫行为更多是为了获取数据用于AI训练,但在如今的网络环境里,爬虫攻击绝非什么善茬,它们攻击性极强,且带来的损失也很严重。根据Akamai近日发布的最新SOTI报告《侵蚀您的利润:网络爬虫程序对电商行业有何影响》显示,爬虫活动目前依旧活跃在各行各业中,尤其是电商领域,其爬虫活跃度的增长趋势要显著高于其他行业。

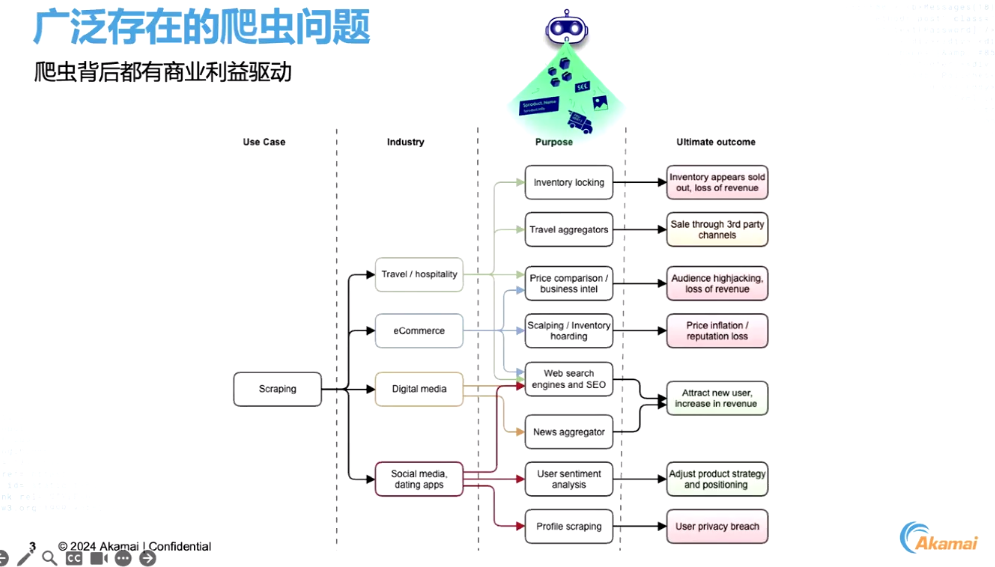

Akamai北亚区技术总监刘烨表示,广泛存在的爬虫问题背后实际都有商业利益驱动。以电商行业为例,爬虫可被用来抓取商品价格、分析竞争对手策略以制定自身定价方案,甚至可能利用脚本抢占库存、购买促销商品后转售牟利的非法行为。

Akamai北亚区技术总监刘烨

而在数字媒体领域,爬虫则可能被用于新闻聚合,这种行为有很大可能会损害原创者的收益和收入。甚至在社交媒体上,用户的隐私信息同样面临被非法爬取的风险。因此,无论是哪个行业,爬虫问题的背后都有着复杂的商业动机。

从定义上讲,爬虫实际上是“Robot”(机器人)的缩写,它包含一段能够模拟正常用户行为的代码。但与浏览器不同的是,爬虫在执行任务时更为高效,且针对性更强,可以迅速抓取目标信息。根据爬虫的行为性质和影响,可以分为善意爬虫、中性爬虫和恶意爬虫三类,善意爬虫如搜索引擎为信息流通和检索提供了便利;中性爬虫往往很嘈杂,尽管它们仍然是合法的;它们实际上是好机器人的一个子类别,包括不断发送请求的合作伙伴机器人和其他频繁调用程序API的机器人;而恶意爬虫则多被用于撞库攻击、库存抓取等行为,这些行为往往都会损害企业的利益。

以撞库攻击为例,攻击者会利用从暗网等非法渠道获取的海量用户名和密码列表,通过自动化程序登陆其他网站,以寻找可复用的凭证。这种手段不仅威胁到用户的账户安全,还可能使企业遭受重大损失。

除了撞库攻击外,“库存抓取”机器人也是另一个常见威胁,攻击者会在秒杀或者限量场景下,通过机器人程序或者爬虫将低价或者限量商品抢购一空,然后在自己的平台上高价售卖,这不仅扰乱了市场秩序,也严重损害了企业的合法权益和利润。

“当然,恶意爬虫可被用于违法行为并不能说明爬虫技术或者机器人应用都是有害的,例如搜索引擎爬虫就有助于提升企业的网络可见度和营收;聊天机器人则能显著提升企业运营效率,至于监控机器人,可以通过定期检查系统的健康状况来确保业务运行的稳定性和连续性。因此,在应对爬虫问题时,我们应该采取分而治之的策略,一方面要严厉打击恶意爬虫,另一方面也要合理利用中性或有益的爬虫资源,以实现技术与商业的双赢。”刘烨总结道。

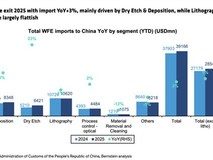

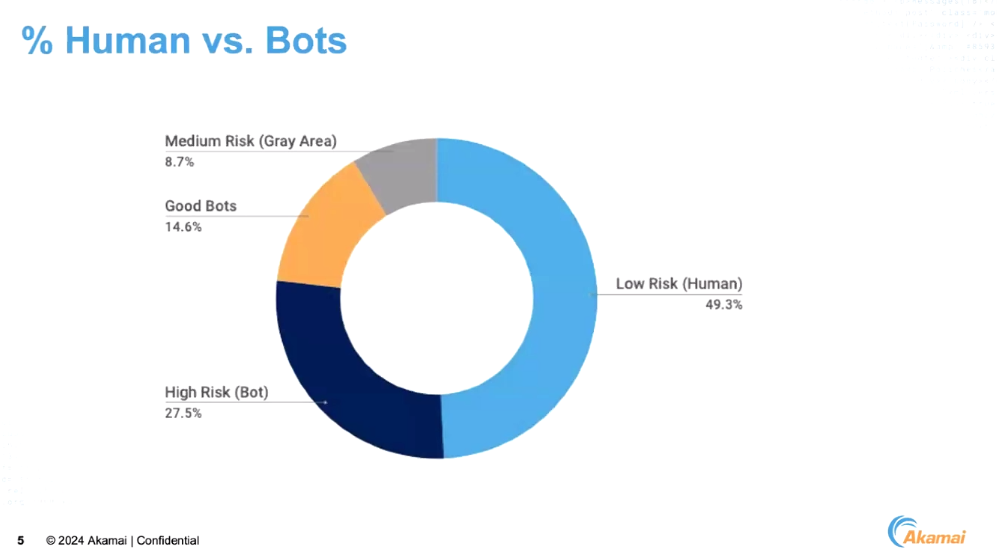

上文中提到,在电商行业,来自爬虫的威胁要比其他行业更高,这能够从爬虫行为的占比上得到直观的体现,根据Akamai的机器人管理程序统计的针对电商网站的69亿次请求中,人类的访问行为仅有49%,而剩下的51%都来自各类机器人爬虫,在进一步分析后,在这51%的访问行为中,又有27%来自高风险类别的爬虫,有益的爬虫占比为14%,而中性的爬虫只占8.7%,这无疑凸显了电商领域爬虫活动的普遍性和复杂性。

对不法分子而言,他们往往会对电商网站中的热销商品下手,即先通过爬虫广泛搜集销售这些产品的网站数据,包括价格、库存等信息,随后通过对比分析找出价格最优、优惠力度最大的电商平台,随后基于该信息在另一个平台开设店铺,以准新或者全新未开封的产品进行转售,利用价格优势赚取非法收入。

当然,爬虫为电商平台带来的威胁远远不止于此,由于爬虫行为与真实用户的访问行为数量相当,且爬虫通常会部署在云端或高性能服务器上,所以访问效率要远超普通用户,这往往会导致电商网站在处理爬虫请求时消耗大量资源,最终影响正常用户的访问体验,降低网站转化率。此外,爬虫还会干扰市场营销分析工具的数据收集,导致决策依据失效。同时由于部分爬虫会抓取特定产品页面的深层链接,导致这些页面因为请求量过大而无法正常服务。最后,当爬虫抓取或者整合大量内容后,原始的创作者可能会失去宝贵的流量和收入来源。

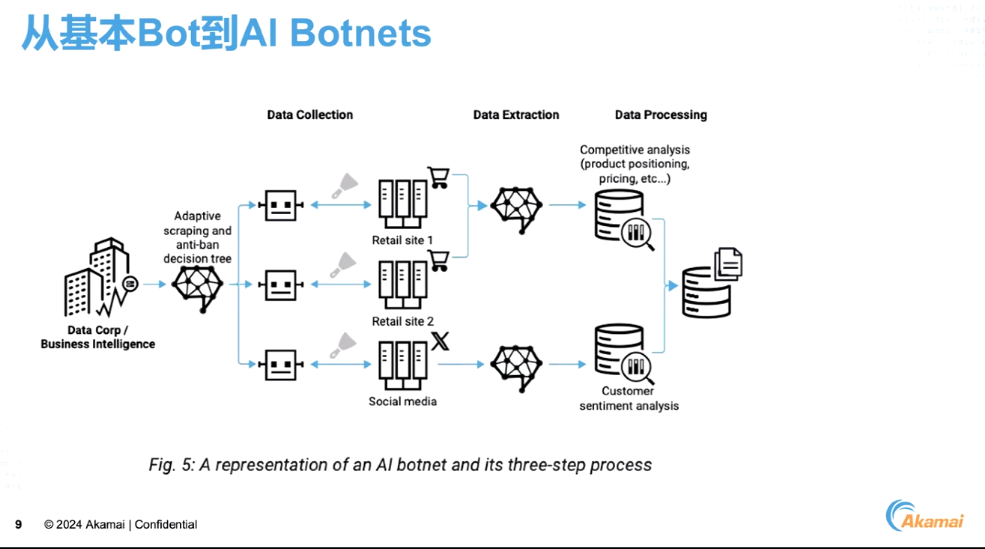

更加雪上加霜的是,在电商领域,设计或编写一个爬虫程序并非难事,有些公司会对外提供“爬虫即服务”(Scraper as a Service,SaaS)的解决方案,这类解决方案不但简化了爬虫的开发流程,还提供了丰富的功能选项,如内容抓取、数据分析等等,虽然这类服务大多数都聚焦于中性的爬虫应用,即帮助用户进行市场调研、竞品分析等非恶意活动,但也存在被滥用的风险。

如今,随着AI和机器学习等技术的进步,爬虫服务也愈加智能化,它们能够自动从多个数据源抓取内容,并通过预设的逻辑进行数据抽取和分析,并辅助用户指定竞争策略、优化产品定位以及价格策略等,这种一站式解决方案无论对寻求业务增长的合法用户还是意图不当的恶意使用者都提供了极大的便利。

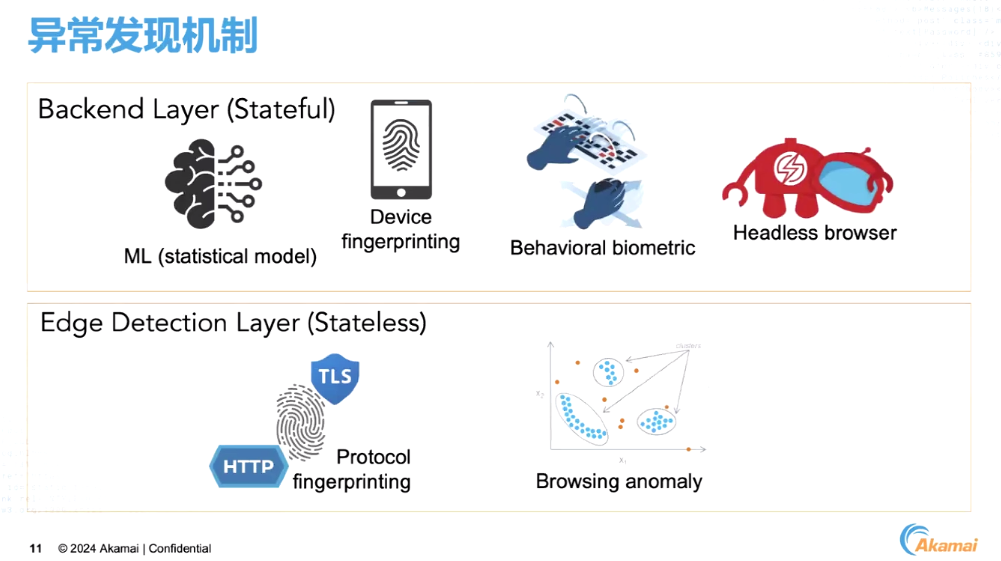

但对电商网站的所有者来说,识别爬虫特别是恶意爬虫却愈发艰难,随着爬虫技术的隐蔽性越来越强,部分采用“无头浏览器”技术的爬虫甚至能够模拟人类的访问行为,这使得传统的安全手段难以实现有效的识别与拦截。针对这一问题,Akamai提出了双重应对的策略。

首先,在边缘网络层面,利用预定义的访问特征和协议指纹来快速识别并限制恶意爬虫。

其次,通过深入分析访问行为(如鼠标移动轨迹、键盘敲击模式)和设备指纹,结合机器学习模型进一步细化识别精度,确保对潜在威胁实现精准打击。

针对不同类型的爬虫,Akamai还提供了差异化的解决方案。对于扫描漏洞、抓取内容或窃取用户信息的恶意爬虫,Akamai会为客户提供更加严格的防护机制;而对那些有助于提升网站质量或服务的良性爬虫,则会采取更加灵活的管理策略。

当然,对任何一家企业而言,并非部署了安全服务就可以高枕无忧,因为真正的安全永远是产品+服务+意识+教育等一系列的组合,从企业安全素养的角度来看,建立安全团队是十分有必要的,特别是对电商行业来说,因为电商行业设计买卖、用户账户信息、送货地址等各种敏感数据,即便企业规模比较小,也可以考虑和第三方安全公司合作,来识别重要资产、薄弱环节和需要保护的内容,而非急于部署产品。

在确定了自身的薄弱环节后,企业应该有针对性地选择能够应对这些威胁的安全产品。同时在使用这些产品时,也需要安全运营团队的支持,因为很多安全问题未能很好的解决问题并不是产品本身有缺陷,而是因为策略未进行调优或服务为未达到最佳状态。

最后,一旦出现漏洞或问题,企业也需要有紧急预案。同时也应该在平时加强对公司整体的安全教育,很多勒索事件并不是从安全人员入手,而是从普通员工的终端被攻入开始,进而一步步跳板到核心资产。

“Akamai一直在强调多层防护,这包括基础架构、应用开发逻辑、数据中心和网站等各个方面,涉及到Bot攻击、应用层攻击以及行为上的恶意攻击等等。于企业而言,在建立长期安全策略时,除了了解自身资产、合理运用安全服务和制定应急预案外,也需要关注整体的安全状况,实施多层防护,并清楚识别所有财产,这是确保没有环节出现问题的关键。”刘烨在最后表示。

本文属于原创文章,如若转载,请注明来源:电商领域爬虫攻击依旧泛滥 Akamai如何提供应对手段?https://safe.zol.com.cn/889/8898424.html